导言

- 背景问题:传统RL的算法和奖励都要特殊设计,并且不同领域迁移性很差;

- 想法: 能不能系统自己迭代产生适合的RL算法

- 构建一个能够表征广泛强化学习规则的搜索空间,让系统通过多代智能体在复杂环境中的交互经验,元学习(Meta-Learning)出最优的强化学习更新规则。[^1]

导言

Bridging the Gap: Challenges and Trends in Multimodal RL.

导言

快速调研多模态强化学习及其ai infra(verl类似)的下一步方向、技术点和与LLM RL的差异点:

导言

Pytorch 2.5 :Dataset & Dataloader

导言

Why Choose Quantitative Finance

导言

为什么之前认为金融只是调配资源,并不产生生产价值的我。也会想搞量化。

导言

第一次相亲(第二次见面)

导言

第一次相亲

导言

相亲是展现真实自我,寻找志趣相投另一半的过程。

Ideas around Vision-Language Models (VLMs) / Reasoning Models

导言

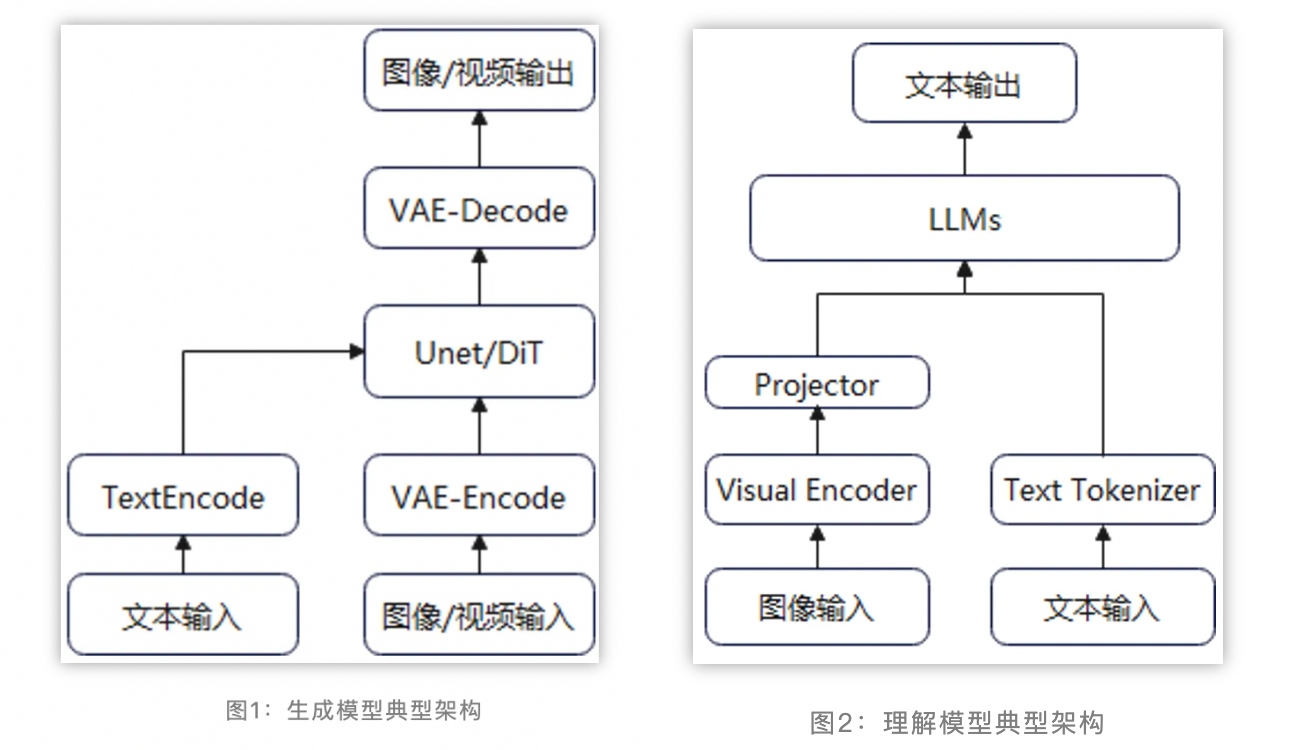

当前主流的多模态理解模型一般采用视觉编码器 + 模态对齐 + LLM的算法流程,充分复用已有视觉编码器的理解能力和LLM的基础能力。训练过程一般分为多个阶段,如先进行模态对齐的一阶段预训练,然后进行二阶段的参数微调。

排行榜:

导言

vllm 的ray后端属实奇诡,ray stop有残留,flush打印被吞(虽然输出能标记ip,折叠重复,在master输出),ray集群的环境变量固定不变导致DP无法实现多机。

为此考虑使用torchrun实现多机并行。

写得太好了,由浅入深。