导言

VeOmni 是字节跳动与火山引擎联合研发的 统一多模态训练框架,核心目标是解决多模态模型(如 DiT、LLM、VLM、视频生成模型)训练中的碎片化问题,实现 “统一多模态、统一并行策略、统一算力底座”。其经过千卡级真实训练任务验证,支持从百亿级语言模型到 720P 视频生成模型的全流程训练。[^1]

导言

VeOmni 是字节跳动与火山引擎联合研发的 统一多模态训练框架,核心目标是解决多模态模型(如 DiT、LLM、VLM、视频生成模型)训练中的碎片化问题,实现 “统一多模态、统一并行策略、统一算力底座”。其经过千卡级真实训练任务验证,支持从百亿级语言模型到 720P 视频生成模型的全流程训练。[^1]

导言

VeRL场景开发时,安装包特别多和复杂:

开发时还要pip install -e . 还要修改代码。

传统的思路是docker镜像或者conda打大包,但是这种包一个就是20GB+,但是这是商发时的策略,开发时即使只是修改一行,但是还是要重新出一个20GB大包。

思路是借助并加速pip的原子化构建:

pip intall -r requirements.txt就行。导言

论文中提及的数据训练,分数上涨和饱和的描述总结

World Model/UFMs/Omni-Modal: AR vs DiT

导言

视觉领域的GPT moment要来了吗?[^4]

当前多模态设计中AR和DiT的组合关系,单独学习一下

vllm-omni & DiT Inference Accelerate

导言

vllm专门为了多模态单独推出了推理框架vllm-omni,调研一下

导言

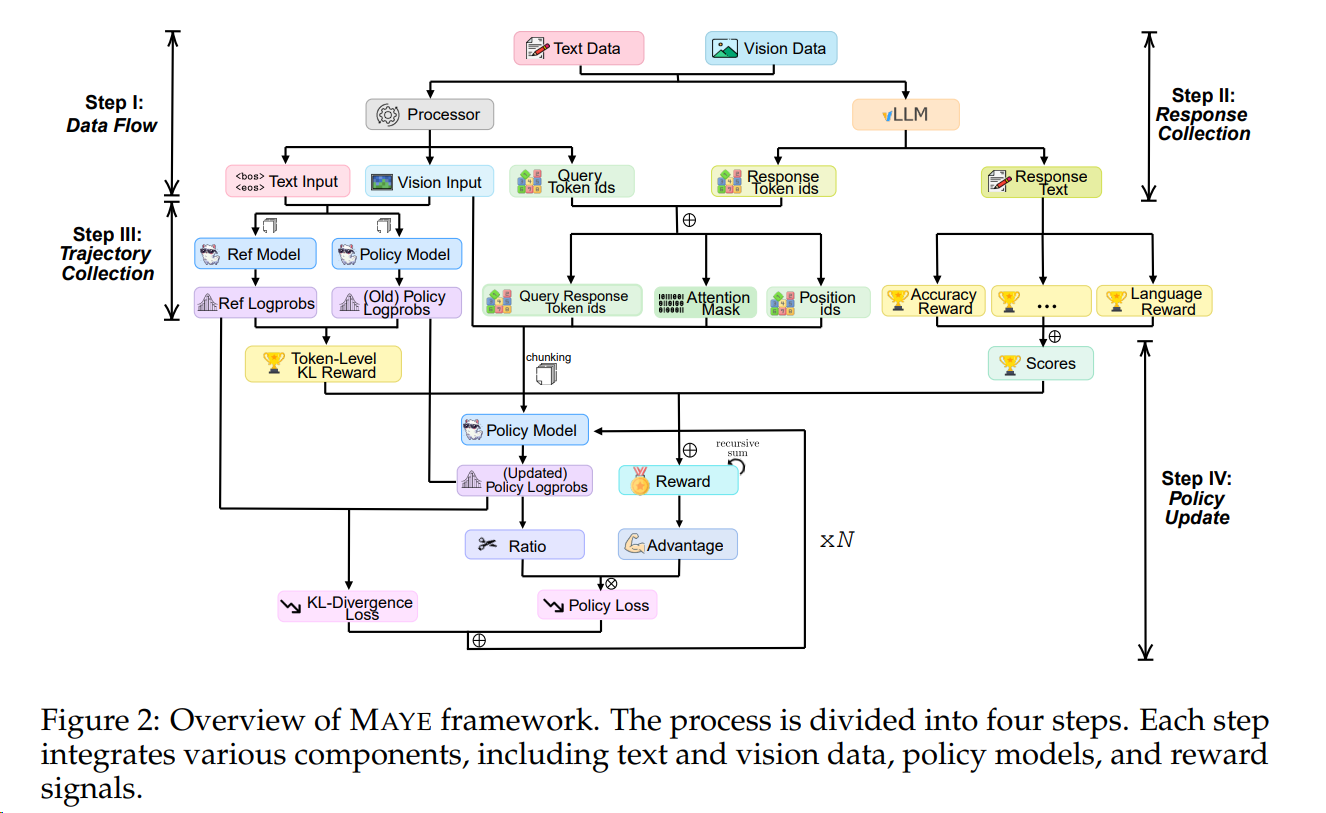

VeRL 作为RL领域趋势最火的开源仓,值得学习。

导言

VeRL 基于ray的多进程管理,并结合 推理、训练等多个阶段。其E2E时间组成和如何加速都是待研究的课题。

Pytorch 7 :Memory Optimization(Freeing GPU/NPU Memory Early)

导言

Train Stages: Pretrain, Mid-Train(CT), SFT, RL

导言

模型训练,为什么需要这么多阶段,每个阶段的独特职责和意义是什么。

RL Algorithms: PPO-RLHF & GRPO-family

导言

[^1]

[^1]

必看好文[^2]