简介

漫画或者PDF的jellyfin版本 , 类似的还有 基于docker的smanga

选择

Rather than browse rouman online, high-resolution pivix pictures seems more worthy to be downloaded and maintained.

But first you need a much bigger NAS.

安装

- 通过Docker安装(Docker on Windows 体验不好)

- 通过java运行

Windows

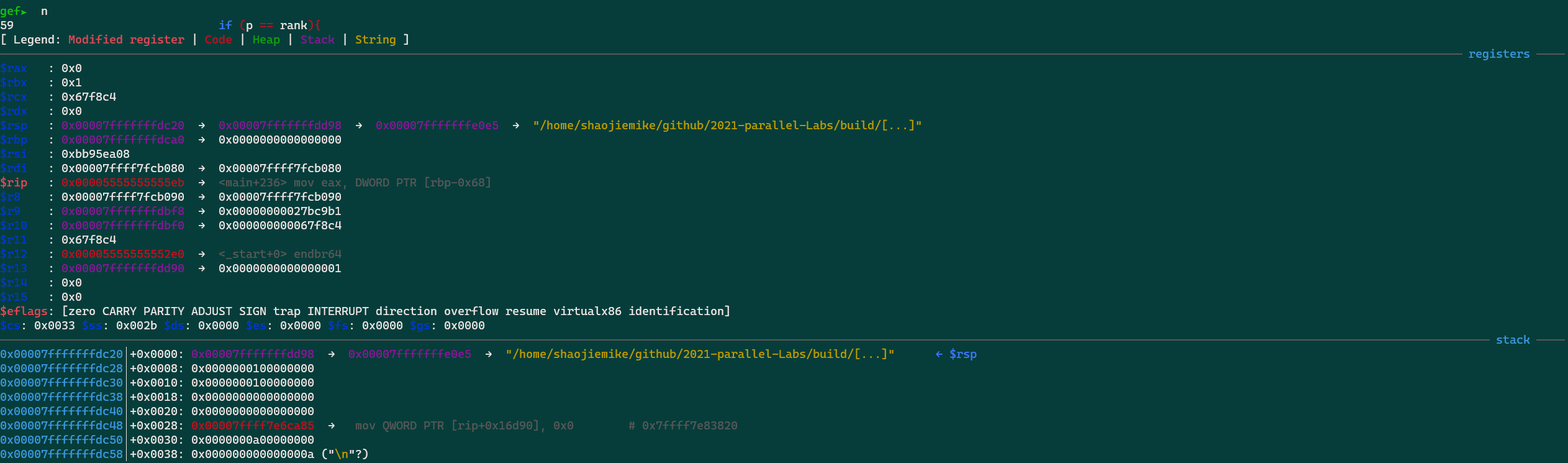

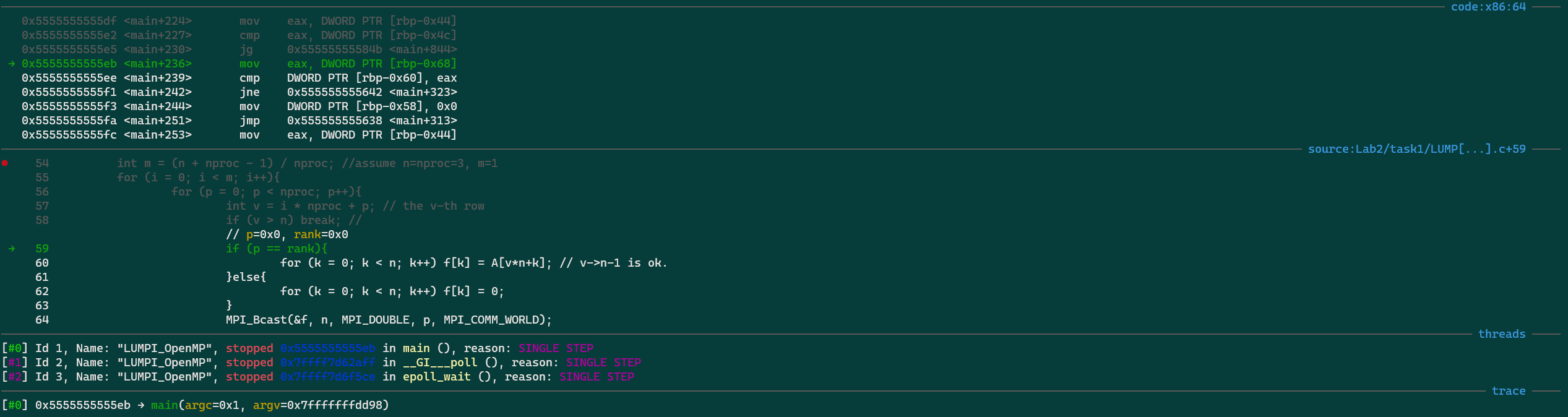

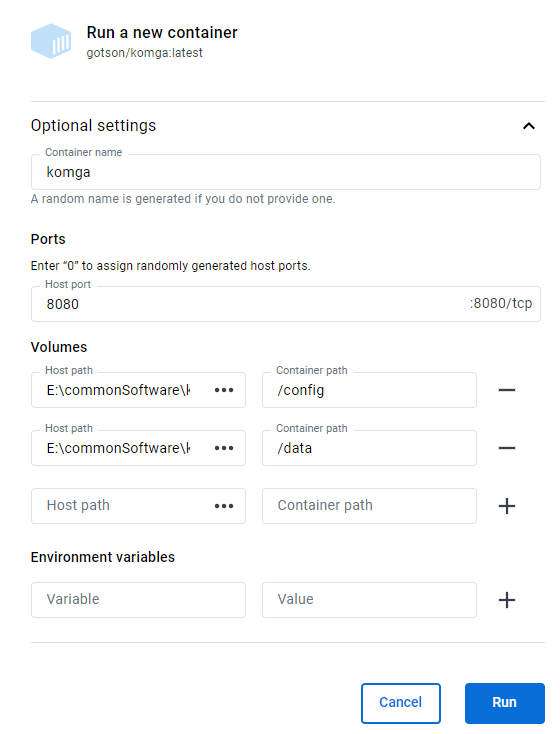

- 由于在portainer.io里路径有问题,选择直接在docker里点击

image run创建容器。 - 如果输入数据来源多,建议设置子目录

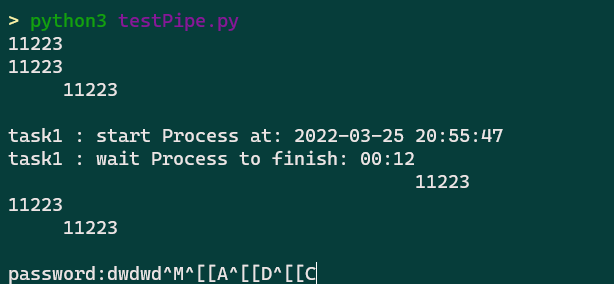

data/1anddata/2。 and Please think carefully because restart container will triger the following bugs:

But docker on Windows remains many bugs:

- Failed to restart the docker engine

- deadlock between first free volume to delete container and first stop already stepped container to free related volume.

Linux docker

In http://brainiac.acsalab.com:2333/

step1: map remote data to local visual disk

- map windows disk to linux

- map Nas disk to linux

sudo mount.cifs //synology.acsalab.com/Entertainment /synology -o user=xxx vers=3.0

Step2 : docker

采取第一种, 在 portainer.io的local的stack里使用docker compose部署

1 | --- |

Docker in Ugreen Nas

- easy pull official

komgaimage - set mount disk

- set port

komga V.S. smanga V.S Kavita

- exhentai-manga-manager only on widnows

- smanga,

- 优点:

- 带标签和收藏,维持三级目录,

- 独特的目录设计。

- 缺点:

- png读取正常,但是zip解压过于缓慢

- PDF的支持暂时欠缺:

- 元数据不能自由编辑,只能编辑标签。

- 不能读取根目录的文件,但是能选择单行本,或许可以解决这个问题,但是需要尝试。

- 无法读到过深的文件夹。

- 小结:本来寄希望于这个all in one, 但是问题太多,还是只适合刮削好的资源。 可以不断完善和尝试。

- 举例:所有韩漫,

- 优点:

- Kavita

- 优点:

- 纯zip文件能读到深处的文件夹

- 日漫带标签和收藏,有缩略图。

- 元数据能自由编辑

- 缺点:

- 奇怪的文件名识别规则,导致

- 杂乱的类型(zip, png, pdf)会导致目录混乱

- 不能读取根目录的文件

- 小结:适合高度组织过后的内容

- 举例:2022单行本,零散日漫单行本。和calibre处理后的文件。

- 优点:

- komga

- 优点:

- 维持原始目录结构,稳定简洁。

- 元数据能自由编辑

- 根目录文件能识别

- 缺点:

- 没有收藏,保存和标签等功能,不适合碎片化连续看。

- 小结:适合混乱的内容,靠文件夹的并列和包含关系,维护逻辑关系。

- 举例:杂志(没有子文件夹包裹,识别不了),漫之学院(太大),日漫大合集(混乱的结构)

- 优点:

需要图书/漫画刮削

| dockers | komga | smanga | Kavita |

|---|---|---|---|

| 单一大PDF文件加载 | 缓慢 | 缓慢 | |

| 格式支持 | zip,cbz,pdf | 部分zip不支持bug,不支持cbz | zip,pdf ,cbz |

| 如何支持单文件夹多图片 | 每个文件夹单独压缩成zip反而支持 | :material-close: | |

| 自定义元数据 | :material-close: | :material-check: | :material-check: |

| 任意位置标签 | :material-close: | :material-check: | :material-check: |

| 已知bug | 容器会自动关机(有待进一步测试) | ||

| 总体评价 | 基础完善稳定,但是定制化不足 | 有用的定制化 | 全,但是不维持原目录有点恶心,导致必须按照类型整理。 |

其余未汉化版本

推荐文件结构

kativa

1 | Library Root |

- Kavita enforces that all files are within folders from the library root. Files at library root will be ignored.

- kativa 会将不符合文件夹命名

Series Name的新文件(e.g.,abc.cbz),当作新的作品单独列出在根目录。这十分傻逼,对内容的共振度的要求也太高了。出现一个命名不规范的文件就会乱套。 - kativa 对文件类型也会做特殊处理,对png, cbz, zip文件会有不同的阅读器,最搞笑的是 kativa会把子章节cbz的同名图片单独用个文件夹放置,而不是识别出章节的封面图,kativa会读取子章节cbz的内容当作封面图。

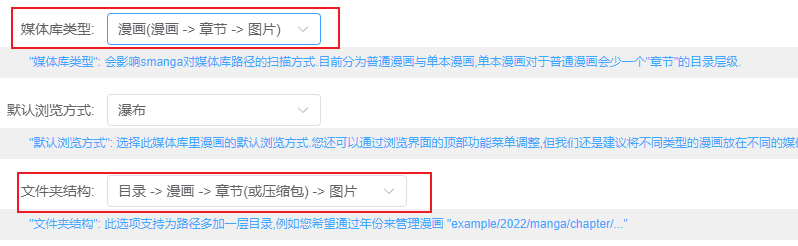

smanga

可以看得出作者有特殊的设计。

但是美中不足的是对于子文件夹的支持不够,太深的文件读取不到。

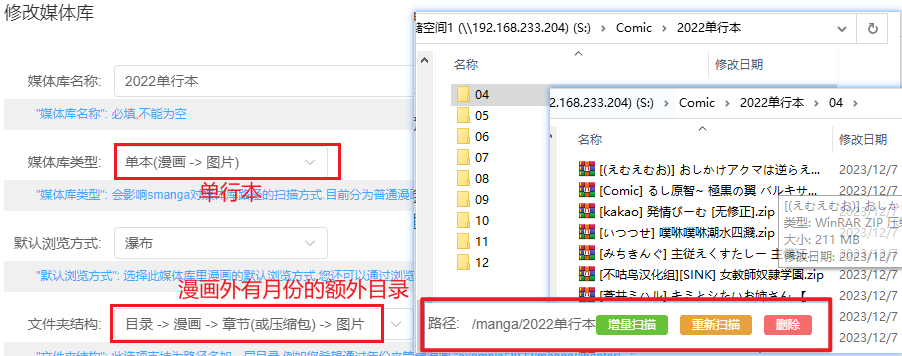

单行本

理论如此,但是实际貌似会卡住。

komga

Komga支持CBZ/CBR、EPUB、PDF格式。对于漫画而言,个人觉得cbz1是最简单、兼容性最高的格式。

建议的文件结构如下:

1 | . |

libraryManga表示库名,下一层结构区分不同的漫画,更下一层则存储漫画文件- komga相对于kavita的异同

- 都不会识别根目录下的文件

- 但是komga不会管Series文件夹的子文件夹,会认为不存在,全部打散。kavata由于命名的原因会将Series文件夹的子文件夹内的内容当作新的系列,提到根目录显示。

内容的组织

需要考虑的点

内容的组织考虑的是一个平衡,每个lib下应该只有40个左右的内容。

- 根据类别分类:

- 韩漫,日漫,杂志

- 根据时间分类:每个月大约有50部左右

下载的内容的特点:

- 日漫,很多是单行本没有系列的,所以系列的这一级文件夹可以使用时间代替

- 有些库太大了,估计有一千本漫画(漫之学院),必须分开。

- 有些库还是识别不了

合集/A/PDF/*

实践

看多少,刮削多少。

内容的刮削

calibre + ehentai

见 Calibre and its Pugins for e-hentai Books 一文

失败:BangumiKomga

- 一个从Bangumi获取元数据并填充的Python脚本。

- 但是自动识别刮削的成功率很低,强烈建议在Bangumi中先找到对应漫画后把链接贴到Komga系列作品链接处,标签写为

cbl,配置好后在目录下运行python processMetadata.py,即可近乎完美的给漫画加上海报和信息了 - 但是Bangumi又没有本子的内容

集成订阅平台:tachidesk

尝试后发现是,类似RSS的漫画网页集成浏览器(B站,腾讯漫画,18+漫画)。实现订阅,跟踪,一键下载。 由于生态很不错,不用担心订阅链接失效。

Bugs docker stopped in UGREEEN

我猜测是内存不够

需要进一步的研究学习

暂无

遇到的问题

暂无