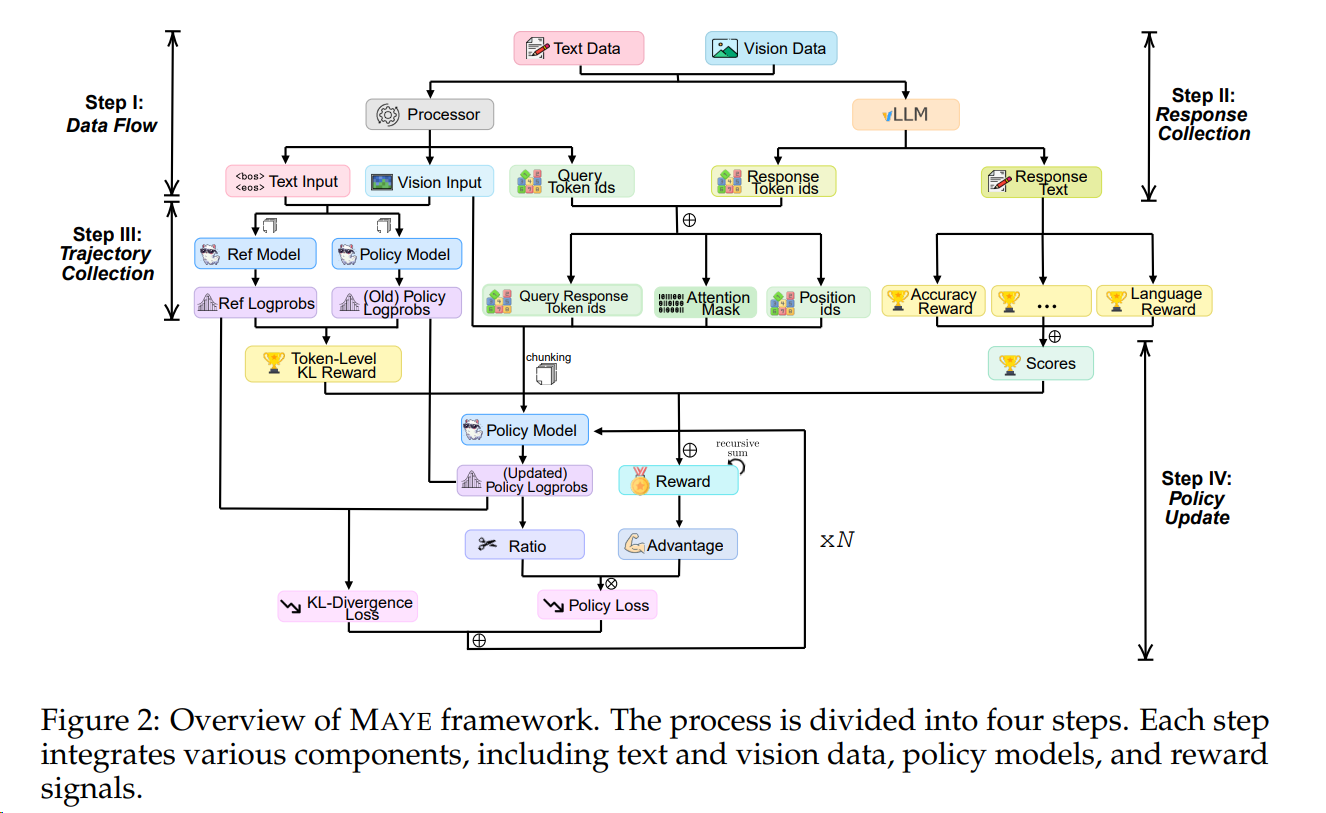

Train Stages: Pretrain, Mid-Train(CT), SFT, RL

RL Algorithms: PPO-RLHF & GRPO-family

导言

- RLHF 利用复杂的反馈回路,结合人工评估和奖励模型来指导人工智能的学习过程。(RLHF = 人类偏好数据 + Reward Model + RL(如 PPO), 所以RLHF是RL的一种实践方式)

- 尽管DPO相对于PPO-RHLF更直接,但是(Reinforcement Learning from Verifiable Rewards (RLVR))往往效果更好;

- 而RLVR算法在 2025年的GRPO提出后,其变种和应用范围迎来了井喷爆发。

- 本文详细介绍 PPO、GRPO以及DAPO。

[^1]

[^1]

必看好文[^2]

导言

- 背景问题:传统RL的算法和奖励都要特殊设计,并且不同领域迁移性很差;

- 想法: 能不能系统自己迭代产生适合的RL算法

- 构建一个能够表征广泛强化学习规则的搜索空间,让系统通过多代智能体在复杂环境中的交互经验,元学习(Meta-Learning)出最优的强化学习更新规则。[^1]

Bridging the Gap: Challenges and Trends in Multimodal RL.

导言

快速调研多模态强化学习及其ai infra(verl类似)的下一步方向、技术点和与LLM RL的差异点:

- 说实话有点头大

- 多模态理解模型的主体就是LLM,LLM的RL基本半年后会迁移到多模态理解上,所以我要跟踪LLM RL的文章

- 多模态生成模型的RL偏向DPO为主的另一条路子;

- 多模态还涉及agent、具身智能,RL又有些不同;

- 文章多到看得头大。

Ideas around Vision-Language Models (VLMs) / Reasoning Models

导言

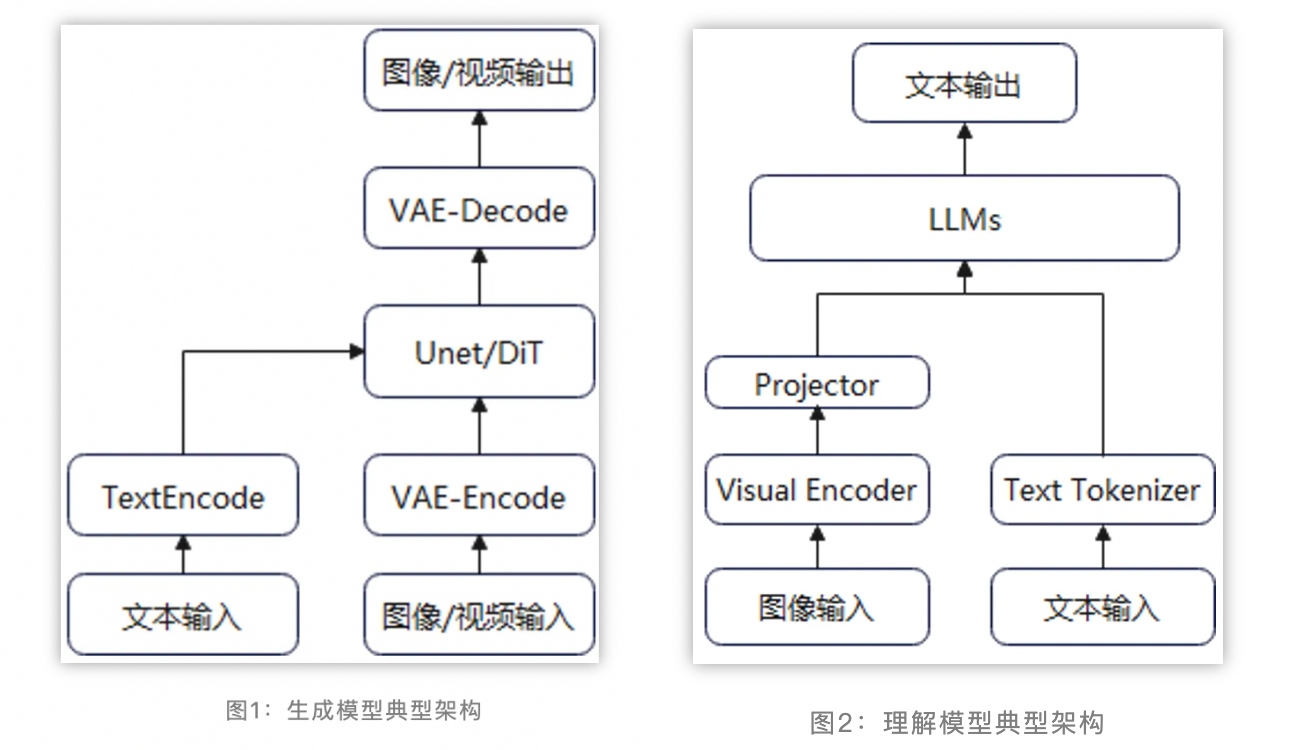

当前主流的多模态理解模型一般采用视觉编码器 + 模态对齐 + LLM的算法流程,充分复用已有视觉编码器的理解能力和LLM的基础能力。训练过程一般分为多个阶段,如先进行模态对齐的一阶段预训练,然后进行二阶段的参数微调。

排行榜:

导言

vllm 的ray后端属实奇诡,ray stop有残留,flush打印被吞(虽然输出能标记ip,折叠重复,在master输出),ray集群的环境变量固定不变导致DP无法实现多机。

为此考虑使用torchrun实现多机并行。

写得太好了,由浅入深。

导言

作为卖NPU AI加速卡的软件员工, 目标是将昇腾的底层算力与上层多模态应用需求精准对接,释放昇腾AI算力,让客户看到NPU的性能、性价比、易用性、客户自身业务的使用需求。

导言

在LLM对齐的早期探索中,研究者们建立了两种影响深远的基础范式。

- 一种是基于强化学习的PPO,它将经典的RL框架引入LLM微调,通过复杂的系统协调实现了强大的性能;

- 另一种是DPO,它通过深刻的理论洞见,将对齐问题转化为一个更简洁的监督学习问题,显著提升了训练的稳定性和效率。

鉴于PPO-RLHF的复杂性,研究者们开始寻求更简洁、更直接的对齐方法。直接偏好优化(Direct Preference Optimization, DPO)应运而生,它巧妙地绕过了显式的奖励建模和复杂的RL优化循环,为偏好对齐提供了一个优雅的替代方案。

这篇文章介绍DPO, 和Step-Video论文介绍了Video-DPO, 这类训练中最后通过人工标注优化的方法。

必看好文[^7]

导言

Step-Video论文详细介绍了AI 系统的一些构建细节。

250217 Step-Video-T2V Reading & Porting

导言

阅读Step-Video-T2V代码(git id d3ca3d6),移植到昇腾。

Categories

- AI6

- Algorithms12

- Architecture41

- Artificial Intelligence42

- Camp1

- Databases2

- HPC1

- Math2

- Network8

- OOW35

- Operating system8

- Overview15

- Programming39

- ProjectRecord3

- Software1

- Thinking11

- Tips9

- Treasure1

- Tutorials118

- Values2

- architecture2

- diary4

- english4

- hardware2

- love1

- math3

- network19

- operating system5

- programming1

- security3

- software23

- thinking9

- tips5

- toLearn55

- values2

Subscribe for updates

follow.it

Archives

- February 20262

- January 20267

- December 202518

- November 20255

- October 20251

- September 20252

- May 20253

- April 20251

- March 20254

- February 20254

- January 20254

- December 20245

- November 20241

- October 20245

- September 202411

- August 20243

- July 20244

- June 20241

- May 20242

- April 20248

- March 20243

- February 20241

- January 202414

- December 202320

- November 202333

- October 202358

- September 202337

- August 202323

- July 202324

- June 202313

- May 202319

- April 20239

- March 20235

- February 20232

- January 20236

- December 20222

- November 20224

- October 20225

- September 20224

- August 20228

- July 20227

- June 20227

- May 202210

- April 20225

- March 20227

- February 20222

- January 20225

- December 20214

- November 20212

- October 202114

- September 202111

- August 202113

- July 202128